- 登入

- 註冊

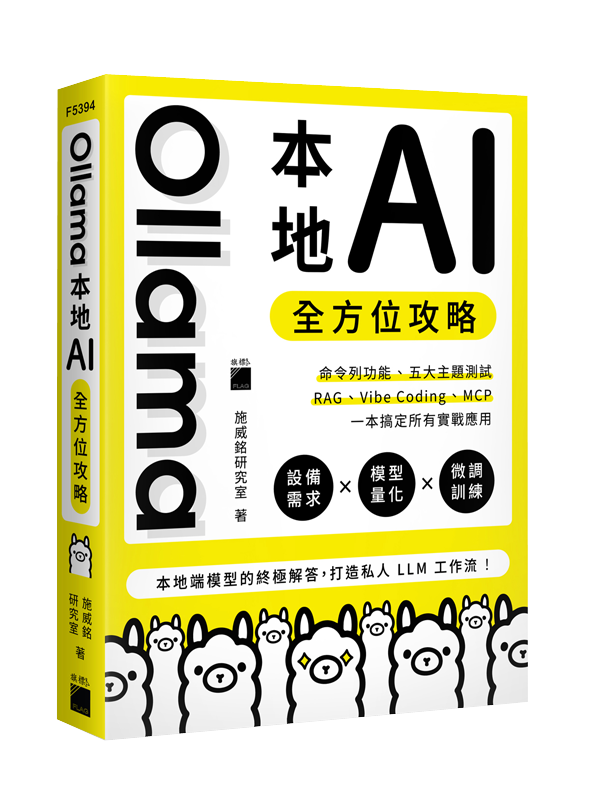

Ollama 本地 AI 全方位攻略

NT$750

本地端模型的終極解答,打造私人 LLM 工作流!

10 件庫存

1.1 本地部署框架簡介

LM Studio

GPT4All

Text Generation Web UI

LocalAI

1.2 為什麼選擇 Ollama?

Ollama 的系統架構

透過 Modelfile 自定義模型

擁有 REST API 的強大整合能力

1.3 從零開始安裝 Ollama

安裝 Ollama

關閉 Ollama

更新 Ollama

1.4 Ollama 的對話介面

下載第一個模型並開始交談

1.5 模型儲存位置管理

Ollama 模型的儲存位置

更改模型儲存位置

1.6 ChatGPT 不好嗎?為什麼要在本地端跑 AI 模型

自己部署 AI 模型的好處

本地部署 vs 使用線上 AI 服務▌第 2 章 Ollama 的命令列操作

2.1 Hello LLM!與模型互動的基本操作

查詢模型資訊

跟 LLM 打個招呼吧!

多行輸入

清除對話紀錄

中斷模型輸出

儲存與延續先前對話

關閉對話

2.2 Ollama 的各種命令

下載模型

模型列表

運行模型

顯示運行中的模型

停止運行模型

刪除模型

模型資訊

2.3 透過 Modelfile 客製化模型

Modelfile 指令

建立客製化模型

查看模型的 Modelfile 資訊

2.4 推送模型到自己的帳戶

取得金鑰並建立 Ollama 帳戶

複製模型

推送模型到官方▌第 3 章 Ollama 的進階系統設定

3.1 Ollama 的環境變數

可使用的環境變數

3.2 透過暫時的環境變數來啟動 Ollama

3.3 設定系統環境變數

Windows 的環境變數

macOS 的環境變數

3.4 Ollama 的 GPU 設定

GPU 加速

確認是否有用到 GPU 加速

▌第 4 章 模型的設備要求以及速度測試

4.1 模型格式簡介

浮點數精度 FP

量化 Quantization

其他壓縮方式

4.2 Ollama 是如何載入語言模型?

運行狀況測試

Mac 的統一記憶體架構優勢

4.3 建議設備要求

設備建議

4.4 模型速度測試

▌第 5 章 各種預訓練模型介紹

5.1 具不同功能的模型

Embedding 類模型

Vision 類模型

Tools 類模型

Thinking 類模型

5.2 各有特色的預訓練模型

Gemma3

Llama3

Phi-4

Mistral

DeepSeek-R1

Qwen3

GPT-OSS

5.3 模型功能測試比較

測試主題 1:知識性問答與繁體中文理解

測試主題 2:多語言翻譯能力

測試主題 3:數學能力

測試主題 4:邏輯推理能力

測試主題 5:程式碼生成

▌第 6 章 從 Hugging Face 下載模型、轉檔以及量化

6.1 直接從 Hugging Face 下載 GGUF 檔案

6.2 自行下載 safetensors 檔案

申請授權以及 Read Token

安裝 llama.cpp 套件並輸入 Token

下載 safetensors 模型

6.3 轉換模型格式為 GGUF

6.4 模型量化

透過 llama-quantize 進行量化

撰寫 Modelfile 來創建新模型

▌第 7 章 Ollama 視覺化對話介面

7.1 Ollama UI 對話介面推薦

應用程式:AnythingLLM、Chatbox、Msty

擴充功能:Page Assist

網頁介面:Open WebUI

7.2 下載 Open WebUI

安裝 Open WebUI

啟動 Open WebUI

7.3 Open WebUI 使用教學

介面設定

下載模型

開始對話操作

網頁搜尋功能

串接 ChatGPT

串接 Gemini

▌第 8 章 透過 Ollama API 和官方套件輕鬆存取 LLM & 打造 RAG 架構

8.1 使用 Ollama REST API 與模型溝通

透過 curl 安裝和啟動 Ollama

使用 curl 測試 API

8.2 在 Python 中呼叫 Ollama API

使用 requests 發送對話請求

將模型回覆轉換為 DataFrame 表格

8.3 使用 Ollama 套件

單次對話回覆

模型超參數設置

接續聊天機器人

圖片辨識

函式呼叫

8.4 建構 RAG 架構

加入搜尋功能

建立向量資料庫

文件問答機器人

統整總結機器人

▌第 9 章 Fine-Tuning 微調模型 — 打造你的產品客服機器人

9.1 什麼是微調模型?

9.2 準備訓練資料集

訓練資料格式

自動生成 QA 問答資料集

9.3 模型微調訓練

透過 Unsloth 微調模型

程式碼說明以及微調設定

▌第 10 章 Ollama 也能 Vibe Coding

10.1 在 VS Code 中調用 Ollama

挑選適合的模型

安裝 Continue 並配置模型

在 VS Code 中啟用虛擬環境

10.2 用 AI 來開發一個網頁小遊戲吧!

程式碼生成與補全

除錯與程式優化

生成註解與文件

使用較小模型時的下指令技巧

管理上下文窗口與對話歷程

延伸學習:大型專案的好幫手 Roo Code

10.3 在使用 LLM 進行 Coding 時, 你需要注意什麼?

▌第 11 章 哎呀,Ollama 得了 MCP!

11.1 MCP 是什麼?

MCP 的架構

11.2 馬上讓 Ollama 跟 MCP 相遇吧!

Playwright MCP Server - 幫你直接操作瀏覽器的神隊友

Context7 MCP Server -幫你查詢官方文件的專業顧問

11.3 管理自動執行權限與排除錯誤

管理 MCP 執行的核准權限

排除錯誤